De:CrawlStart p

Inhaltsverzeichnis

- 1 Indexerzeugung - Crawl starten

- 1.1 Eigenschaften des Crawls

- 1.1.1 Startpunkt

- 1.1.2 Lesezeichen erstellen

- 1.1.3 Crawling Tiefe

- 1.1.4 Muss-entsprechen Filter

- 1.1.5 Muss-nicht-entsprechen Filter

- 1.1.6 Re-crawl bekannter URLs

- 1.1.7 Auto-Dom Filter

- 1.1.8 Maximale Seiten pro Domain

- 1.1.9 Akzeptiere URLs mit '?' / dynamische URLs

- 1.1.10 Speichern im Web-Cache

- 1.1.11 Lokales Indexieren / Indexieren auf anderen Peers

- 1.1.12 Nutze Remote Indexierung

- 1.1.13 Statische Stop-Words ausschließen

- 1.2 weitergehende Infos

- 1.1 Eigenschaften des Crawls

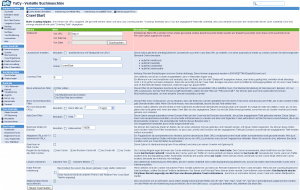

Indexerzeugung - Crawl starten

Diese Seite ist im Bereich Index Kontrolle -> Indexerzeugung über die Adresse http://localhost:8090/CrawlStart_p.html zu erreichen und ermöglicht das Starten von neuen Webcrawls durch die Erstellung eines neuen Profils. Sollten Sie ein Administrator-Passwort definiert haben, so müssen Sie sich mit diesem anmelden.

Eigenschaften des Crawls

Startpunkt

Nun können Sie unter "Startpunkt" bei "von URL" ihre gewünschte URL eintragen (z.B. www.domäne.de).

- Von URL: Hier können Sie einfach eine Webseite in der Form http://www.domäne.de oder http://www.domäne.de/seite.html eingeben. Diese wird dann mit der oben angegebenen Crawl-Tiefe indiziert.

- Von Sitemap: Wenn die unter "Von URL:" angegebene Domain eine Sitemap in der robots.txt Datei listet wird diese hier angezeigt und kann als Ausgangspunkt für einen Crawl verwendet werden.

- Von Datei: Hier müssen Sie ein vollwertiges HTML-Dokumtent mit einem Skript oder einem Editor Ihrer Wahl erstellen. Alle Links, welche in dieser HTML-Datei durch <a href="http://www.domäne.de">Text</a> auftauchen, werden automatisch mit der Crawl-Tiefe "1" indiziert. Unter Linux kann eine Liste mittels

splitzeilenweise aufgeteilt werden. Einsplit -l 10000 Links.dberzeugt Dateien mit je 10000 Zeilen unter den DateinamenLinks.dbnn.

Lesezeichen erstellen

Diese Option gibt Ihnen im Zusammenhang mit der "Von URL:" Option die Möglichkeit ein Lesezeichen aus der Crawl Start URL zu erstellen.

- Titel: Hier können Sie dem Lesezeichen einen Namen geben.

- Ordner: Um diese URL automatisch regelmäßig zu crawlen, können Sie die folgenden Standardordner benutzen:

- /autoReCrawl/hourly

- /autoReCrawl/daily

- /autoReCrawl/weekly

- /autoReCrawl/monthly

Achtung: Recrawl-Einstellungen sind vom Ordner abhängig. Diese können angepasst werden in /DATA/SETTINGS/autoReCrawl.conf.

Crawling Tiefe

Mit dieser Eigenschaft können Sie einstellen, wie tief gecrawlt werden soll.

- Möchten Sie nur genau diese eine Seite indexieren, so wählen sie als Tiefe 0.

- Möchten Sie die eingetragene Seite und die direkt verlinkten Seiten indizieren, so wählen sie 1.

- Möchten Sie die eingetragene Seite und die direkt sowie die indirekt verlinkten Seiten indizieren, so wählen sie 2.

- ...

Ein Minimum von 0 wird empfohlen und bedeutet, dass die Seite, die Sie unter "Startpunkt" angegeben haben, dem Index zugefügt wird, verlinkter Inhalt allerdings nicht. 2-4 ist gut für normales Indexieren. Seien Sie vorsichtig mit der Crawl-Tiefe. Erwägen Sie einen durchschnittlichen Verzweigungsfaktor von 20; eine Crawl-Tiefe 8 wird 25.600.000.000 Seiten indexieren, vielleicht sogar das ganze Web.

Muss-entsprechen Filter

Hier können Sie steuern welche URLs der Crawler aufsammelt. Sie haben drei Möglichkeiten:

- Filter nutzen Dieser Filter ist ein regulärer Ausdruck, der mit den zu crawlenden URLs übereinstimmen muss; standard ist 'sammel alle'.

Beispiel: Um nur URLs zuzulassen, die das Wort 'Wissenschaft' beeinhalten, setzen Sie den Filter auf '.*Wissenschaft.*'.

- Auf Startdomain beschränken Wenn diese Auswahl aktiviert ist, bleibt der Crawler auf die Domain der Start-URL beschränkt. Es wird empfohlen, die Crawl-Tiefe zu erhöhen, damit auch wirklich alle Seiten innerhalb der Domäne indiziert werden!

Beispiel: Ein Crawl von Von URL: http://www.server.de/ordner/index.html würde alle verlinkten Seiten mit dem Filter .*www.server.de.* crawlen.

- Auf Sub-Pfad beschränken Wenn diese Auswahl aktiviert ist, bleibt der Crawler auf den aktuellen Unterordner der Start-URL beschränkt.

Beispiel: Ein Crawl von Von URL: http://www.server.de/ordner/index.html würde alle verlinkten Seiten mit dem Filter http://www.server.de/ordner/.* crawlen.

Muss-nicht-entsprechen Filter

Mit diesem Filter können explizit URLs vom crawlen ausgeschlossen werden. Dazu kann wiederum ein regulärer Ausdruck eingetragen werden. Bleibt das Eingabefeld leer, ist das Filter deaktiviert und es werden keine URLs vom crawlen ausgeschlossen.

Re-crawl bekannter URLs

Ist diese Option aktiviert, werden bereits in der YaCy Datenbank existierende Internetseite erneut gecrawlt und indexiert. Es hängt vom Alter des letzten crawlens ab, ob eine Seite erneut gecrawlt wird oder nicht. Wenn der letzte Crawl älter als der angegebene Zeitraum ist, wird die Seite erneut gecrawlt, ansonsten wird die URL aus Doublette aussortiert und verworfen.

Auto-Dom Filter

Diese Option erzeugt automatisch einen Domain-Filter der den Crawl auf die Domains beschränkt, welche auf der angegebenen Tiefe gefunden werden. Diese Option kann man beispielsweise benutzen, um eine Seite mit Bookmarks zu crawlen und dann den folgenden Crawl automatisch auf die Domains zu beschränken, die in der Bookmarkliste vorkamen. Die einzustellende Tiefe für dieses Beispiel wäre 1. Die Standard Einstellung 0 beschränkt die Suche nicht.

Maximale Seiten pro Domain

Sie können die maximale Anzahl an Seiten, die von einer einzelnen Domain gecrawlt und indexiert werden, mit dieser Option begrenzen. Sie können diese Option auch mit dem 'Auto-Dom-Filter' kombinieren, so dass das Limit für alle Domains mit der angegebenen Tiefe gilt. Domains außerhalb der angegebenen Tiefe werden aussortiert.

Akzeptiere URLs mit '?' / dynamische URLs

Ein Fragezeichen ist normalerweise ein Hinweis auf eine dynamische Seite. URLs mit dynamischem Inhalt sollten normalerweise nicht gecrawlt werden. Manchmal gibt es jedoch Seiten mit festem Inhalt, die nur von URLs zu erreichen sind, die ein Fragezeichen enthalten. Wenn Sie unsicher sind, aktivieren Sie diese Funktion nicht, um Crawl-Schleifen zu vermeiden.

Beispiel: www.domäne.de/index.php?seite=start

Speichern im Web-Cache

Benutzen Sie YaCy gleichzeitig auch als Proxy-Cache, so können sie die gecrawlten Webseiten im Proxy-Cache zwischenspeichern, damit ein Zugriff im Wiederholungsfall schneller erfolgen kann. Dies ist in aller Regel jedoch nicht notwendig.

Lokales Indexieren / Indexieren auf anderen Peers

Dies aktiviert die Indexierung von Webseiten, die der Crawler heruntergeladen hat. Dies sollte standardmässig aktiviert sein, außer Sie wollen ausschließlich den Proxy-Cache ohne Indexierung füllen. Die Einstellung kann getrennt für Text und andere Medien vorgenommen werden.

Nutze Remote Indexierung

Hier können Sie bestimmen, wer denn diesen "Crawl-Auftrag" entgegennehmen soll. Wenn aktiviert, wird der Crawler mit anderen Peers Kontakt aufnehmen und diese als Remote Indexierer für Ihren Crawl benutzen. Wenn Sie die Crawling Ergebnisse lokal benötigen, sollten Sie diese Funktion deaktivieren. Nur Senior und Principal Peers können einen remote Crawl initiieren oder erhalten. Eine Nachricht wird im YaCy News Bereich angezeigt, um alle Peers von diesem globalen Crawl zu informieren, damit diese es vermeiden können, einen Crawl vom selben Startpunkt zu starten.

Statische Stop-Words ausschließen

Diese Einstellung zu aktivieren ist sinnvoll, um zu verhindern, dass extrem häufig vorkommende Wörter wie z.B. "der", "die", "das", "und", "er", "sie" etc. in die Datenbank aufgenommen werden. Um alle Wörter von der Indexierung auszuschliessen, die in der Datei yacy.stopwords enthalten sind, aktivieren Sie diese Box.

Abschließend müssen Sie lediglich auf "Crawl Starten" klicken und schon fängt Ihr Rechner an, diese Seite zu indizieren. Den Fortschritt können Sie erkennen, wenn Sie im rechten Menu auf Index Kontrolle -> Crawler Überwachung oder für die Ergebnisse aus Index Kontrolle -> Crawl Ergebnisse klicken.

weitergehende Infos

Eine genauere technische Beschreibung des Crawlers ist unter Crawler verfügbar.

![]() There is an english version of this page.

There is an english version of this page.

Der Crawler liest erst alle robot.txt Dateien ein und startet danach erst mit dem eigentlichen Crawl-Prozess. Dies kann zu dem Eindruck führen, dass nur robot.txt Dateien gelesen würden, was jedoch eine Täuschung ist.